Las redes neuronales artificiales han revolucionado campos como la visión artificial, el procesamiento del lenguaje natural y la robótica. Su capacidad para aprender patrones complejos a partir de datos las hace herramientas poderosas. Sin embargo, el aprendizaje de estas redes no es trivial y requiere algoritmos sofisticados para ajustar sus parámetros internos.

Uno de los algoritmos más fundamentales y ampliamente utilizados para entrenar redes neuronales es el backpropagation, o retropropagación del error. Es el motor que permite a la red aprender de sus errores y mejorar su precisión con el tiempo. Comprender cómo funciona es crucial para cualquiera que quiera incursionar en el aprendizaje profundo (Deep Learning).

El Problema del Error en las Redes Neuronales

El objetivo principal al entrenar una red neuronal es minimizar la diferencia entre las predicciones que realiza y los valores reales. Esta diferencia se define como el error, y es la métrica clave que guía el proceso de aprendizaje. Inicialmente, los pesos de las conexiones entre neuronas se establecen aleatoriamente, lo que produce predicciones erróneas.

La complejidad surge porque el error en la capa de salida depende de la combinación de todos los pesos en la red, incluso los de las capas ocultas. Determinar cómo ajustar cada peso individual para reducir el error global es un desafío significativo. Es fundamental entender que no existe una fórmula directa para este ajuste.

El cálculo directo de cómo cada peso influye en el error sería computacionalmente prohibitivo, especialmente para redes complejas con muchas capas. Por eso, necesitamos un método eficiente como backpropagation para distribuir la responsabilidad del error de manera inteligente.

La Retropropagación del Error: Cómo Funciona

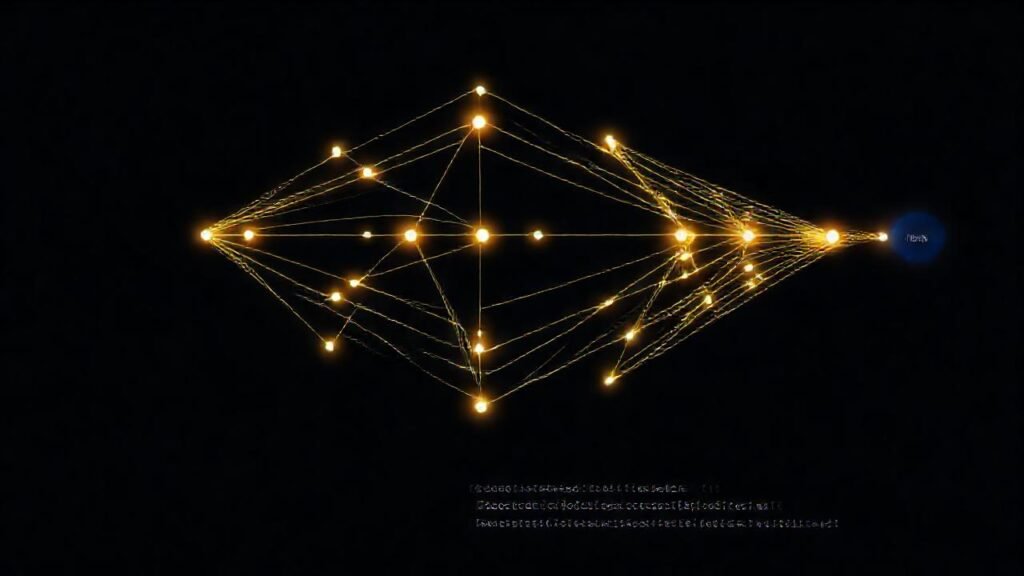

Backpropagation funciona dividiendo el proceso en dos fases principales: propagación hacia adelante (forward pass) y propagación hacia atrás (backward pass). En la fase de propagación hacia adelante, la entrada se alimenta a través de la red, capa por capa, hasta llegar a la capa de salida y producir una predicción.

La fase crucial es la retropropagación, donde el error en la capa de salida se calcula y se propaga hacia atrás a través de la red. Para cada capa, se calcula el gradiente del error con respecto a los pesos de esa capa, indicando cuánto debería cambiar cada peso para reducir el error. Este cálculo utiliza la regla de la cadena del cálculo diferencial.

El gradiente esencialmente nos dice la dirección y magnitud del cambio necesario para cada peso. Un gradiente alto indica que un pequeño cambio en el peso tendrá un gran impacto en el error, mientras que un gradiente bajo indica una influencia menor.

El Descenso del Gradiente y la Tasa de Aprendizaje

Una vez que se han calculado los gradientes para todos los pesos, se utiliza un algoritmo de optimización llamado descenso del gradiente para actualizar los pesos. Este algoritmo ajusta cada peso en la dirección opuesta al gradiente, con el objetivo de disminuir el error.

La tasa de aprendizaje es un hiperparámetro crucial que controla el tamaño del paso dado en cada actualización. Una tasa de aprendizaje alta puede llevar a oscilaciones y a no converger a una solución óptima, mientras que una tasa de aprendizaje baja puede hacer que el entrenamiento sea extremadamente lento.

Encontrar la tasa de aprendizaje adecuada es un arte y se suele realizar a través de experimentación y técnicas como el aprendizaje adaptativo, que ajusta la tasa dinámicamente durante el entrenamiento.

Variaciones y Mejoras del Backpropagation

Existen varias variaciones del algoritmo backpropagation para superar sus limitaciones y mejorar su rendimiento. Una de ellas es el mini-batch gradient descent, donde se calcula el gradiente utilizando un subconjunto de los datos de entrenamiento en lugar de todo el conjunto, lo que acelera el proceso.

Otro enfoque es el uso de optimizadores más avanzados, como Adam, RMSprop y SGD con momentum, que incorporan técnicas para acelerar la convergencia y evitar caer en mínimos locales. Estos optimizadores ajustan la tasa de aprendizaje de manera inteligente en función del historial de gradientes.

Además, técnicas como la regularización (L1 y L2) se utilizan para evitar el sobreajuste, penalizando los pesos grandes y promoviendo modelos más generalizables.

Conclusión

El algoritmo backpropagation es la piedra angular del entrenamiento de redes neuronales profundas. Permite que estas redes aprendan a partir de datos ajustando iterativamente los pesos de sus conexiones para minimizar el error en sus predicciones. Su capacidad para manejar redes complejas y aprender representaciones jerárquicas de los datos lo convierte en una herramienta indispensable en el campo del aprendizaje automático.

Aunque existen algoritmos más avanzados, la comprensión de backpropagation es fundamental para cualquier persona que desee trabajar con redes neuronales. Su aplicación, combinada con técnicas de optimización y regularización, permite construir modelos con alta precisión y capacidad de generalización, impulsando avances significativos en diversos campos de la inteligencia artificial.